A festa acabou para a OpenAI

O vazamento do memorando do Sam Altman não é só fofoca de bastidor. É o registro de um ponto de virada.

Durante quase três anos, depois do lançamento do ChatGPT, a OpenAI viveu como se fosse o padrão do mercado. Primeiro teste de qualquer empresa era sempre com eles. Concorrentes corriam atrás. Preços, narrativa, conferências, tudo girava em torno da OpenAI.

No memorando, o próprio Altman admite que esse ciclo acabou. Ele fala em clima pesado, ventos econômicos contrários, possibilidade real de o crescimento cair para um dígito em 2026 e sinais de esfriamento no engajamento do ChatGPT. A fase da curiosidade e do “brinquedo novo” passou. Agora o que pesa é custo fixo, infraestrutura caríssima e pressão por resultado.

Quando o CEO que sempre vendeu futuro infinito começa a falar em limites, significa que a empresa saiu do modo conquista e entrou no modo guerra.

De líder para perseguidor

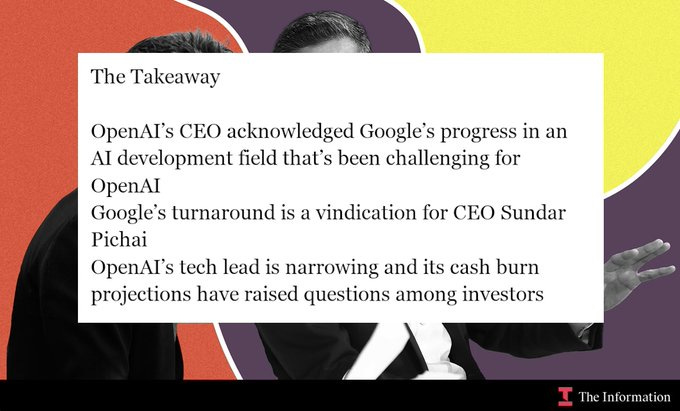

Um dos trechos mais duros é a admissão de que a OpenAI está correndo atrás do Google. Não é mais a empresa que puxa o ritmo sozinha. O avanço do Gemini 3 virou referência.

O ponto não é só a qualidade do modelo. O Google está ganhando em alguns terrenos críticos:

tarefas complexas que exigem raciocínio profundo.

capacidade científica, pesquisa e desenvolvimento de longo prazo.

experiência para quem desenvolve em cima dos modelos, principalmente com código.

integração em um ecossistema gigante que já faz parte da rotina das pessoas.

O Google tem Android, Chrome, Gmail, Docs, YouTube, nuvem própria, chips próprios. A IA encaixa em tudo isso quase naturalmente. A OpenAI, por outro lado, depende da Microsoft para nuvem e distribuição. Menos controle de custo, menos controle de rota, mais fragilidade.

Quando o principal concorrente consegue acoplar IA em tudo o que já domina no dia a dia das pessoas, a disputa deixa de ser só “quem tem o melhor modelo” e vira “quem controla o contexto onde a IA é usada”.

O solo do treino está estragando

Outro ponto incômodo é o problema de base do pré-treino dos modelos. É a parte em que a IA “aprende o mundo” antes de ser refinada.

A metáfora usada internamente é simples: imagine tentar plantar em um solo que já foi explorado até o limite. Durante anos, a estratégia foi escalar: mais dados, mais parâmetros, mais GPU. Agora aparecem dois efeitos colaterais claros:

dados contaminados por conteúdo sintético, com modelos aprendendo em cima de coisas que já foram geradas por outros modelos,

modelos otimizando para “parecerem bons” nos testes, em vez de realmente ganharem profundidade de raciocínio.

A resposta para isso foi criar uma iniciativa específica para repensar o pré-treino, buscar novas formas de selecionar dados, limpar o que está contaminado e usar a própria IA para automatizar parte desse processo. É uma aposta alta. Se funcionar, abre caminho para a próxima geração de modelos. Se não funcionar, vira um buraco de alguns anos e alguns bilhões.

Por trás da metáfora, existe um recado claro: não dá mais para acreditar que só aumentar tamanho e jogar mais internet dentro resolve tudo.

Recado importante: Mais de 83% de desconto e o dobro de tempo de acesso + 45 cursos extras + 1 ano de Alura Língua, pra estudar inglês e espanhol + 1 mês grátis de Lovable Pro, pra colocar tudo em prática + 10% de desconto com cupom exclusivo: PRODUCTGURUS. Acesse aqui.

O contra-ataque do Google com o Gemini 3

Enquanto a OpenAI lida com esses problemas internos, o Google acelerou. O Gemini 3 chega combinando duas frentes: desempenho alto e distribuição agressiva.

De um lado, níveis maiores de raciocínio, melhor desempenho em problemas científicos, tarefas multimodais envolvendo texto, imagem e vídeo e uma janela de contexto gigantesca, suficiente para trabalhar com bases imensas sem gambiarras o tempo todo.

Do outro, presença em tudo o que as pessoas já usam: buscador, navegador, e-mail, documentos, Android, YouTube, nuvem. A IA entra como camada transversal. Não precisa convencer o usuário a abrir mais um app. Ela aparece onde ele já está.

Essa combinação é perigosa para qualquer concorrente. O Google controla a pilha inteira, da infraestrutura ao produto final, e consegue usar isso para reduzir custo efetivo, testar variações mais rápido e empurrar a IA para casos de uso reais em larga escala.

A defesa da OpenAI: código, agentes e compressão de custo

Do lado da OpenAI, a resposta passa por dois movimentos principais.

O primeiro é proteger a posição em desenvolvimento de software com modelos focados em código, capazes de lidar com projetos grandes, manter contexto por mais tempo e reduzir erro em tarefas sensíveis. Há um esforço forte em compactar informações, simular uma memória maior gastando menos recurso e tornar o modelo mais útil em fluxos longos de engenharia.

O segundo é apostar na ideia de usar IA para pesquisar IA. Agentes que ajudam a testar hipóteses, analisar dados de treino, propor ajustes de arquitetura e acelerar o trabalho dos times de pesquisa. A lógica é transformar uma parte da investigação científica em processo semi-automatizado.

Essa aposta esbarra em duas perguntas que ninguém sabe responder com certeza:

até que ponto os modelos atuais conseguem propor coisas realmente novas, e até onde isso é só uma aceleração do que já vinha sendo feito manualmente.

A matemática da IA não fecha sozinha

Por trás da briga técnica, existe uma conta que pesa.

Rodar modelos gigantes é caro. Muito caro.

A combinação de contratos massivos de nuvem, compra de chips, times enormes de engenharia e pesquisa faz com que o custo fixo cresça em uma velocidade difícil de acompanhar com receita. A sensação de “tudo cresce” esconde um detalhe importante: boa parte do dinheiro que entra vem de um circuito fechado.

Funciona mais ou menos assim:

grandes empresas de tecnologia investem bilhões em startups de IA,

essas startups usam boa parte desse dinheiro para pagar nuvem, chips e serviços da própria big tech que investiu,

a big tech registra isso como receita,

investidores veem crescimento e colocam mais dinheiro na roda.

Se a demanda real de empresas e usuários não acompanhar, esse arranjo vira uma mini-bolha. É muita infraestrutura montada para pouco valor concreto revertido em margem.

O memorando do Altman deixa escapar esse incômodo. A mensagem nas entrelinhas é clara: não dá para contar eternamente com dinheiro barato subscrevendo prejuízo de inferência.

Não é uma disputa de dois players

Existe um terceiro ator ganhando espaço: a Anthropic. A proposta dela é ser a opção “mais previsível” para empresas que querem qualidade, segurança e uma relação mais neutra com provedores de nuvem.

O mercado começa a se dividir naturalmente:

modelos mais lentos e caros, usados para problemas difíceis que exigem raciocínio profundo

modelos rápidos e baratos, usados para tarefas operacionais e volume

O Google consegue subsidiar parte do lado rápido usando publicidade e integração com produtos existentes. Isso pressiona ainda mais a margem de quem depende diretamente de contrato de API e assinatura.

O resultado é um cenário em que ninguém manda sozinho e todo mundo tem que justificar o próprio custo.

O que isso significa para você que trabalha com produto

No meio desse fogo cruzado, quem constrói produto precisa ajustar a forma de pensar IA.

Alguns recados práticos:

usar IA não é mais diferencial automático,

escolher um único fornecedor e se amarrar nele por anos é arriscado,

custo de inferência tem que entrar na conta do modelo de negócio desde o início,

o foco precisa sair de “qual modelo é mais hype” e ir para “como eu desenho uma arquitetura que aguenta crescer sem me afogar em GPU”.

Em vez de procurar “o melhor modelo” como se fosse uma resposta definitiva, vale assumir que o cenário vai mudar todo ano. O importante é conseguir trocar peças sem destruir o produto.

Isso vale para qualquer área: produto, engenharia, marketing, atendimento. A pergunta não pode ser “como eu coloco IA aqui”, e sim “que resultado concreto eu preciso gerar e se IA é o melhor caminho para isso”.

A grande mudança trazida por esse momento não é só técnica.

É mental.

Acabou a fase da IA como fetiche. Entrou a fase da IA como custo fixo que precisa se pagar. Quem continuar tratando esse jogo como hype corre o risco de virar só parte da estatística de projetos que queimaram caixa sem deixar legado.