Airbnb, IA e a engenharia de software que não volta mais

Em teoria, levaria 1 ano e meio. Na prática, foram 6 semanas.

Em teoria, levaria 1 ano e meio. Na prática, foram 6 semanas.

O que parecia uma estimativa otimista para migrar manualmente 3.500 arquivos de testes React do framework Enzyme para o React Testing Library virou um projeto radical de automação, com uma pipeline baseada em IA que virou referência global.

Este não é um caso sobre IA gerando código.

É sobre transformar o jeito que grandes equipes estruturam engenharia de software em escala.

O problema: dois mundos em conflito

Desde 2020, a Airbnb já usava o React Testing Library (RTL) para novos testes. Mas milhares de testes antigos ainda dependiam do Enzyme, um framework obsoleto, criado pela própria empresa.

Manter os dois significava:

Dobrar a complexidade mental dos devs.

Aumentar os custos de manutenção.

Correr riscos de qualidade ao excluir testes legados.

O dilema: como migrar 3.500 arquivos complexos sem quebrar nada, sem gastar um ano e meio de engenharia?

A solução: IA com sistema, não com milagre

A equipe testou uma hipótese simples: usar LLMs para automatizar a conversão dos arquivos. Funcionou. Centenas de arquivos foram convertidos em poucos dias.

A partir disso, construíram uma pipeline de produção com 3 pilares:

Arquitetura de estados para rastrear cada passo do arquivo no processo.

Validações automáticas com Jest, Lint e TypeScript.

Loops de tentativa com LLMs, que reescreviam o código com base nos erros até passarem em todos os testes.

Nada disso dependia de um “prompt perfeito”.

O que fez a diferença foi o sistema de retries com contexto expandido: em vez de dar um input mínimo, a equipe alimentava o modelo com até 100.000 tokens, incluindo exemplos reais da própria base de código e 50 arquivos relacionados.

A execução: da força bruta ao refinamento inteligente

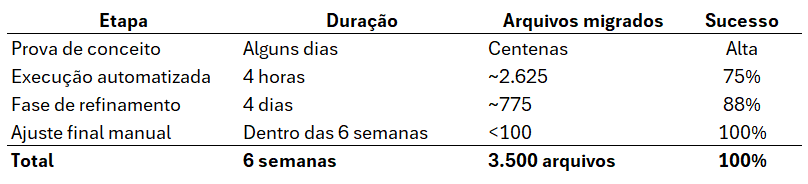

O primeiro run da pipeline levou 4 horas e converteu 75% dos arquivos.

Para os 25% restantes, a equipe criou um processo chamado “sample, tune, sweep”:

Sample: identificar padrões nos erros.

Tune: ajustar os prompts com exemplos específicos.

Sweep: rodar novamente só nos arquivos impactados.

Depois de 4 dias disso, chegaram a 97% de sucesso.

O que sobrou, menos de 100 arquivos, foi migrado manualmente, usando a saída do LLM como ponto de partida.

Os números que mudam tudo

Comparado ao prazo inicial de 78 semanas, é uma aceleração de mais de 13x. Mas mais importante que o tempo é o modelo mental que isso estabelece.

O que a gente aprende com esse caso

Iteração > Prompt perfeito: o segredo não é achar o input ideal, mas sim estruturar um sistema que refine automaticamente.

Validação é tudo: cada Jest, cada erro de lint, cada falha de compilação foi insumo para a IA melhorar.

O papel do engenheiro mudou: de executor para designer de sistemas com IA. A equipe passou a:

Criar a automação.

Alimentar o modelo com contexto útil.

Monitorar e ajustar os loops.

Resolver os edge cases.

IA não é plug-and-play: exige engenharia de verdade, conhecimento profundo do código, domínio técnico e capacidade de construir processos.

O impacto real não está no hype: está na redução de dívida técnica, liberação de capacidade e avanço da maturidade do time.

O que isso significa para o futuro?

Esse projeto da Airbnb muda o patamar da discussão. Não é sobre produtividade individual com Copilot.

É sobre transformar infraestrutura de engenharia com IA como alavanca. E mais: torna viável o que antes era inviável.

Quantas empresas evitam modernizações porque “não vale o esforço”? Agora vale. A IA virou o catalisador que derruba essas barreiras.

A pergunta agora não é se você vai usar IA. É como vai estruturar o sistema que faz isso funcionar.

Artigo sensacional, é nisso que os desenvolvedores devem focar. Uso inteligente da IA e engenharia complexa!